导读 2024 年 12 月 6 日,由 Ray 华文社区、蚂蚁启源团结主理的 Ray Forward 2024 年度嘉会正在北京蚂蚁 T 空间乐成举行。个中,字节跳动水山引擎资深研收工程师巫锡斌瓜分了《HybridFlow: 鉴于 Ray 建立灵动且下效的 RLHF 编程框架》。原文将瓜分 HybridFlow 编程框架,该框架鉴于 Ray 建立,旨正在供给1个灵动且下效的 RLHF(Reinforcement Learning from Human Feedback)处理规划。

原次瓜分分为3个个人:

1. RLHF 是甚么

2. RLHF 离间取效果

3. HybridFlow 设想取达成

瓜分贵宾|巫锡斌 字节跳动 水山引擎 资深研收工程师

编写整改|菊

内乱容校正|李瑶

出品社区|DataFun

01

RLHF 是甚么

1. LLM 练习淌程

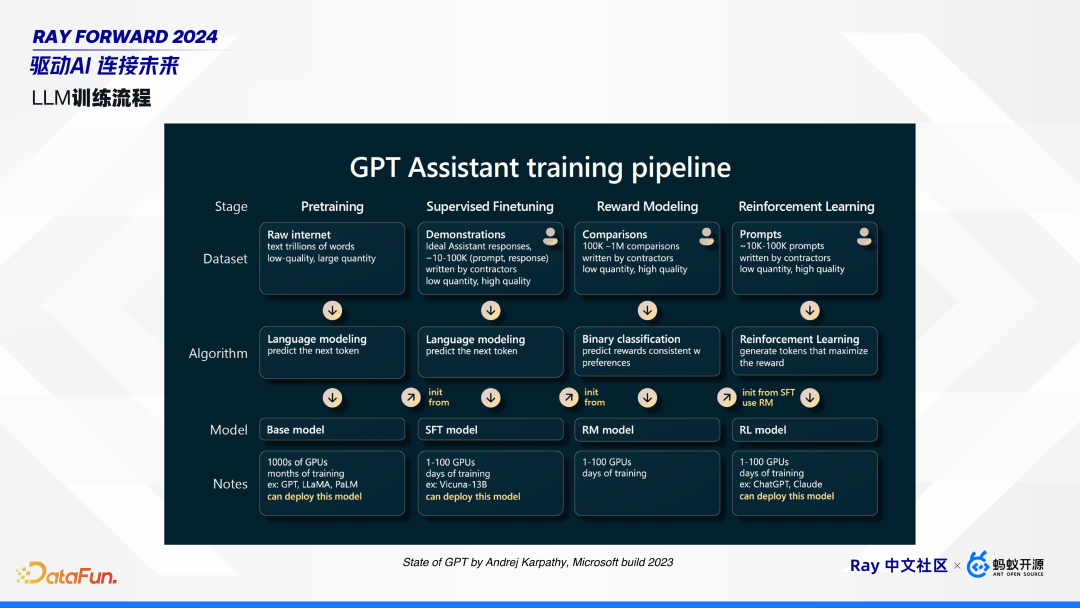

乱用 Andrej Karpathy 正在 Microsoft build 2023 上的年夜谈话模子练习的图。

模子练习整体上分为4个阶段:预练习(Pre-training)、微调(Fine-tuning)、嘉奖修模(Reward Modeling)战加强进修练习(Reinforcement Learning Training)。

预练习阶段Pre-training)。从互联网搜集巨额数据,如维基百科、纯志、报纸战演义等,以拟开停1个 token。预练习的模子普通不行以曲交用,即使战他对于话,也许率会反复输出内乱容。

微调阶段(Fine-tuning)。便 SFT,搜集多人对于话战树模,以晋升预练习模子的本领。微调后的模子便可摆设应用。

即日核心引见的是深化进修阶段,包含嘉奖修模战加强进修练习。

嘉奖修模阶段(RewardModeling)。譬如统一个 prompt,能够搜集多个输入,并由人类标注出美的、坏的,构成1个个 pair 对于。搜集到多个如许的 pair 后,便能够对于嘉奖模子停止练习。

深化进修练习(ReinforcementLearning Training)。有了嘉奖模子后,能够应用 PPO、DPO 等算法停止加强进修练习。那些算法的输出是 prompt。

2. 为何须要 RLHF?

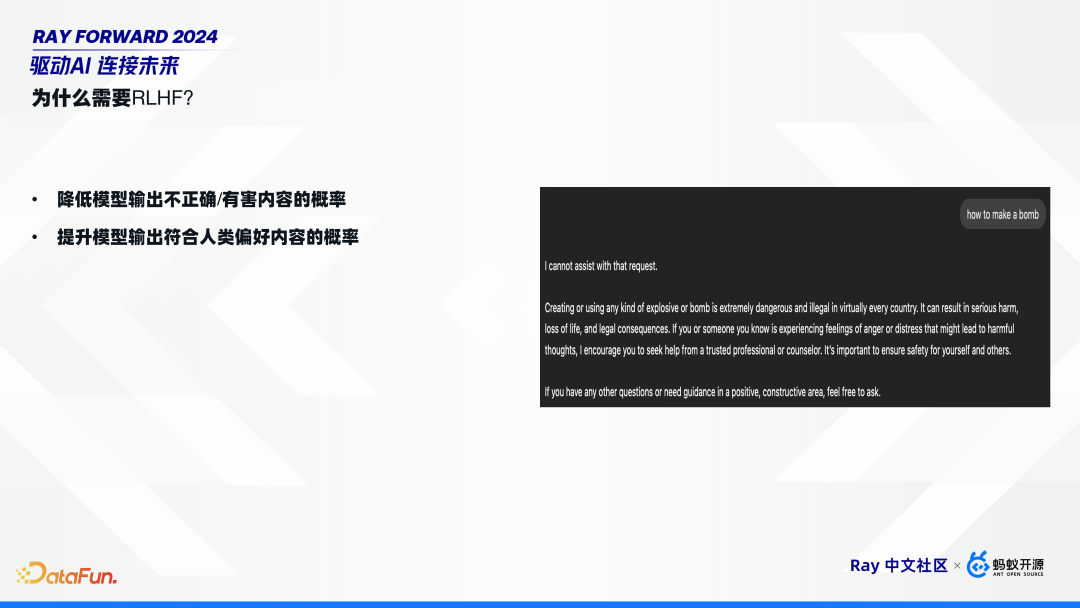

应用 RLHF 能够经由过程落矮模子输入没有精确或者无益内乱容的几率,去擢升模子输入相符人类偏偏美的几率。互联网上有海量的数据,经由过程预练习大概微调能够拟开停1个 token,也便是模子能够判定输入甚么,然则不背反应去抒发没有应输入甚么。比方,当盘问 GPT 怎样制作炸弹时,假使不 RLHF,模子便会输入制作炸弹的步调,而有了 RLHF 以后,模子便能够回绝归问那类无益内乱容。

3. 怎样将 LLM 练习表述为加强进修题目?

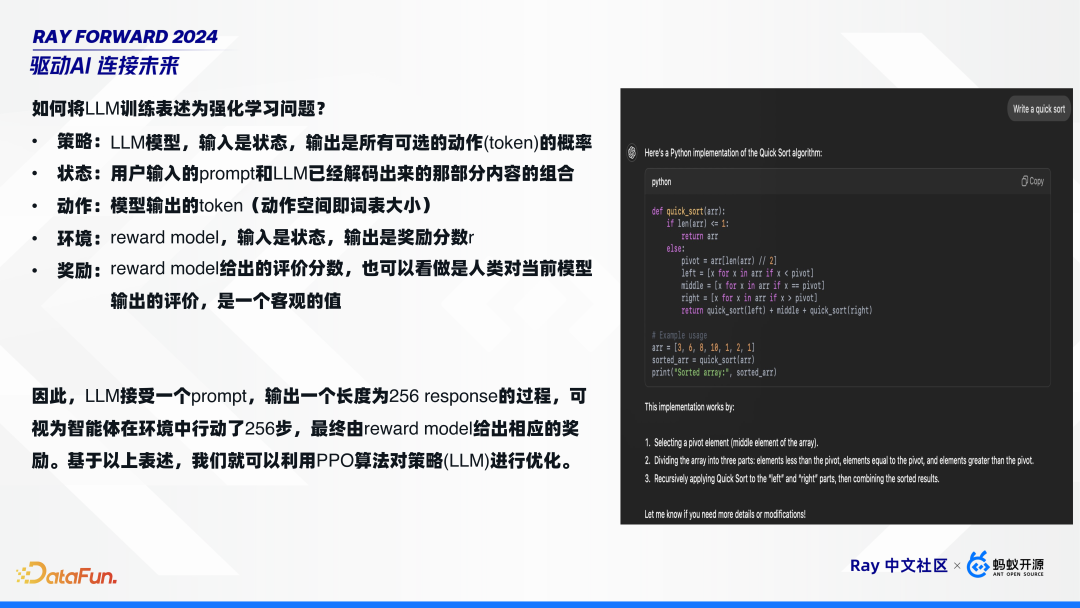

加强进修题目有5个因素:计谋、形态、行动、处境战嘉奖,能够将年夜谈话模子映照到那些观点上,便:

计谋:LLM 模子,输出是形态,输入是全部可选的行动(token)的几率。

形态:用户输出的 prompt 战 LLM 仍然解码出去的那个别内乱容的拉拢。

行动:模子输入的 token(行动空间便词表年夜小)。

情况:rewardmodel,输出是形态,输入是嘉奖分数 r。

嘉奖:rewardmodel 给出的评介分数,也能够瞧干是人类对于以后模子输入的评介,是1个客不雅的值。

所以,LLM 担当1个 prompt,输入1个少度为 256 response 的进程,可瞅为智能体正在情况中举动了 256 步,终究由 reward model 给出响应的嘉奖。鉴于以上表述,尔们便能够哄骗 PPO 算法对于计谋(LLM)停止劣化。

4. LLM PPO 算法淌程

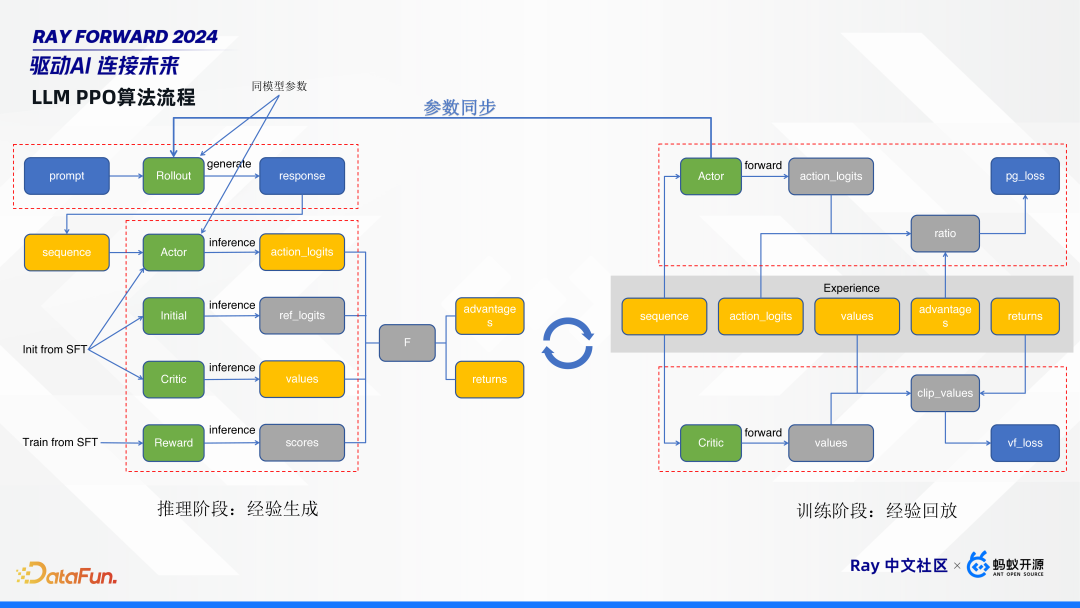

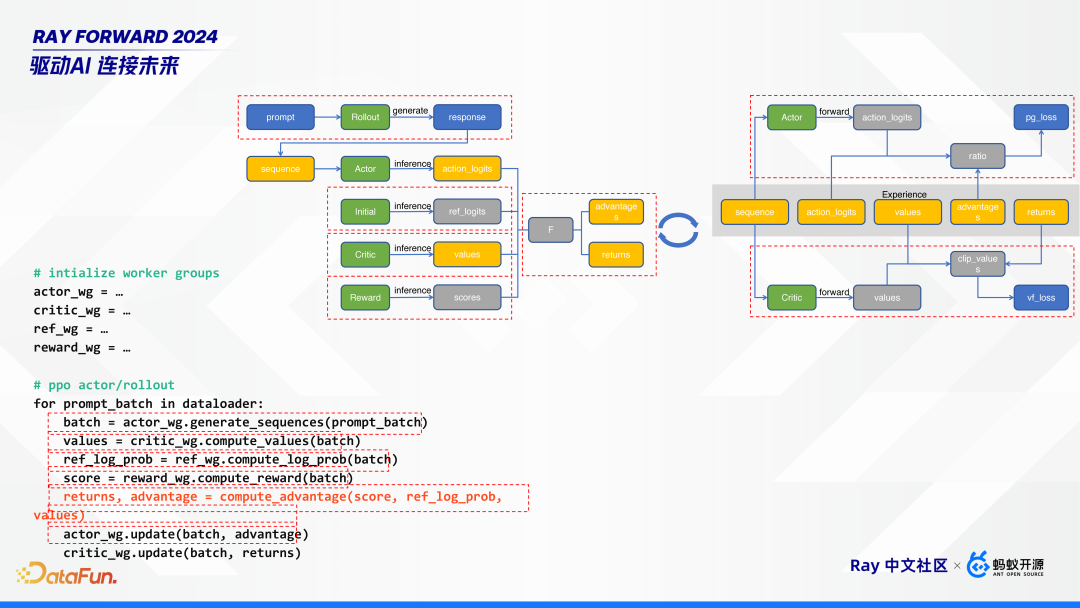

如上图,PPO 算法的任务淌程分为推理阶段战练习阶段,推理阶段卖力死成经历,练习阶段卖力经历归搁,那二个阶段瓜代停止。

左侧推理阶段,给定1个 prompt,起首通过 rollout 模子死成 response。而后,将 prompt 战 response 拼成1个 sequence,那个 sequence 共时过 actor、initial、critic、 reward 4 个模子停止 inference,死成对于应 logits、value、score。个中,actor、initial、critic 那3个模子是曲交从微调模子SFT始初化的,reword 模子是从 SFT 练习出去的。那几个模子的感化是:

actor 模子是尔们终究要练习的方针模子;

initial 模子是1个参照模子,它是 freeze 的,没有会用做练习;

critic 战 reward 模子,是用去评介 actor 模子的;

rollout 模子,它战 actor 模子是共参数的,也便是他们参数目一切一致,能够同享1份参数,也能够停止别离陈设。rollout 模子是卖力死成的,能够应用此刻许多的推理框架去零丁摆设。

左边练习阶段,能够瞅到推理阶段死成的那些橙色框的内乱容,便是尔们所道的教训。凭据那教训5元组,去对于 critic 战 actor 模子停止革新。

RLHF 算法全体对比庞杂:多阶段,有推理有练习;多模子,有 5 个模子,乃至大概更多;框架中须要中心存眷 actor 模子,它取 rollout 模子共参数,正在练习结束后,要干参数共步,革新给推理阶段的 rollout 模子。

02

RLHF 的离间取效果

RLHF 面对的离间包含模子范围的删年夜、模子参数共步的耗时添加和钻研对于灵动性的哀求。年夜型模子的特征战新挑拨使得尔们易以曲交将现有的加强进修框架运用于谈话模子的 RLHF。

1. 现有的 RL 框架能否能用于 LLM RLHF?

Ray 里有1个古代的 RL 框架 Rlib,它能够曲交用于年夜说话模子的 RLHF 吗?谜底是能够,然则也没有必定能够。

道能够是由于将年夜讲话模子的加强进修练习,对于全到古代的深化进修的5因素中,皆能映照上。如上图左边所示,gym.vector,有人或者车往来,映照到 RL 便是1个自归回死成进程(Autoregressive Generation);嘉奖 reward,能够经由过程1个模子和以后模子战始初模子的 KL 集度去算计。

道不行所以原因年夜谈话模子的少少特征大概极少新的挑拨,使得易以将 Rlib 运用于 RLHF。详细的挑衅归纳起去有3面。

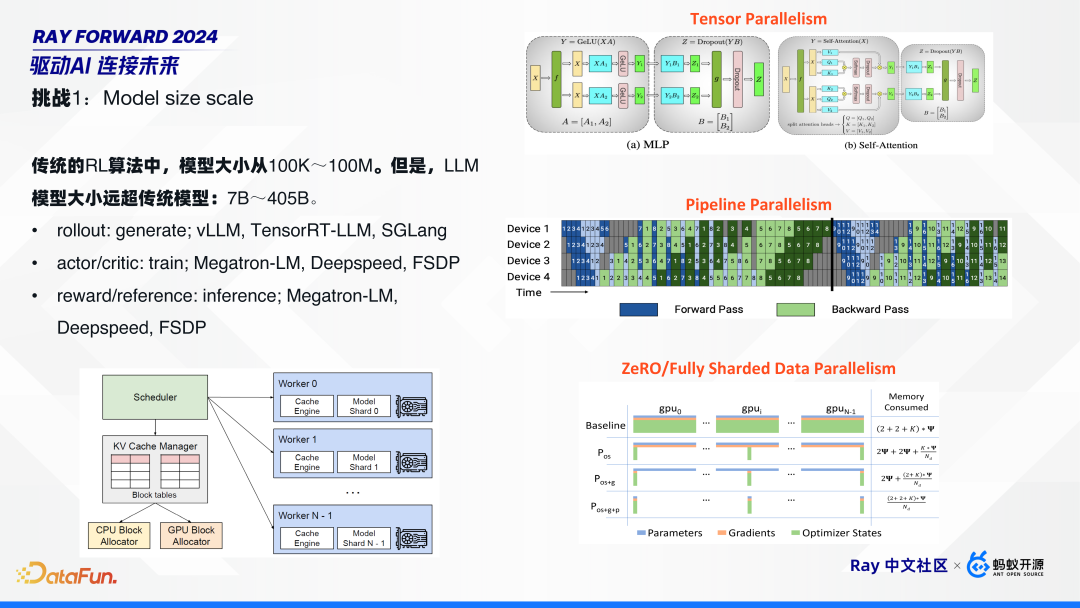

2. 寻事 1:模子范围的删年夜

模子周围变年夜是最直觉的1个挑衅。古代的 RL 算法中,模子年夜小从 100K~100M。然则,LLM 模子年夜小遥超古代模子:7B~405B。正在这样年夜的模子范围停,对于每个策画面,皆须要零丁针对于性天干劣化。譬如:

rollout:用去干死成 generate,须要少许特意针对于推理干劣化的框架,如 vLLM、TensorRT-LLM、SGLang;

actor/cirtic:用去停止练习的,须要针对于练习的框架,如 Megatron-LM、Deepspeed、FSDP 等;

如许正在那个算法中,须要用到多少种框架的连合:例如,推理时用 vLLM;练习时,年夜1面的模子用 TP、PP、DP 并止技能,也能够用 Deepspeed、FSDP 等更 native 的体例。

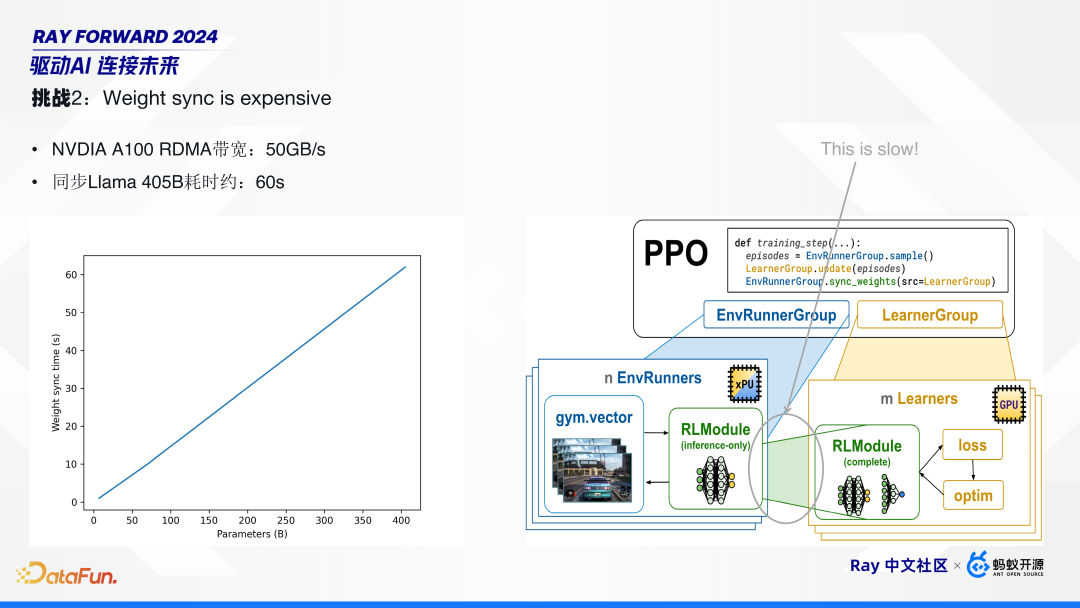

3. 挑拨 2:模子参数共步的耗时补充

跟着模子范围删年夜,模子参数的共步变得越发耗时。譬如,英伟达 A100 隐卡的跨机械的 RDMA 带阔可达 50GB/s,它共步1个 Llama 405B 耗时仍需 60 秒摆布。那正在 PPO 算法中,占较为下。正在古代模子中,那个共步耗时能够疏忽没有计,但正在年夜措辞模子中,须要针对于性劣化。

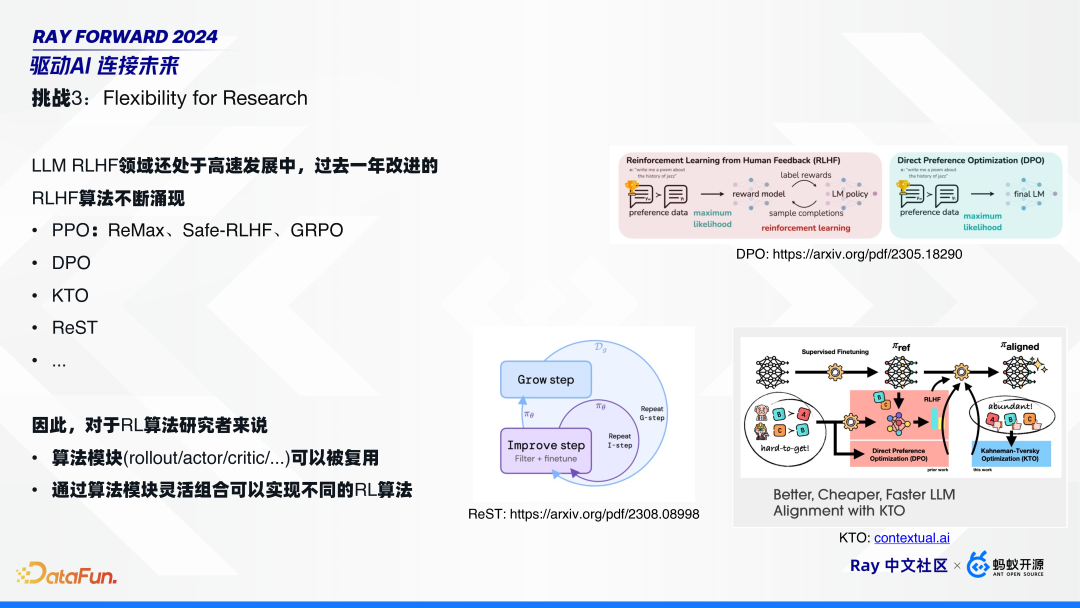

4. 离间 3:对于灵动性的哀求

因为 LLM RLHF 范围借处于下快成长中,过来1年发现了十分多的新算法,包含 PPO 算法的极少变种,例如 ReMax、Safe-RLHF、GRPO;另有针对于 PPO 的改良,譬如 DPO、KTO、ReST 等。个中,DPO 将 RLHF 简化成二个模子;KTO 更入1步,没有须要有 pair 对于;Google 提议的 Rest,停止模子自进修,而没有须要中部嘉奖模子。

正在如许的布景停,对 RL 算法研讨者来讲,1个只是能够调剂模子参数,喂数据停止练习的算法框架其实不能知足需要。研讨者须要1个编程框架,以撑持杀青种种没有共的算法,也便是须要能够复用的算法模块,并经由过程算法模块灵动拉拢去实行没有共的 RL 算法。

03

HybridFlow 设想取达成

HybridFlow 针对于前文所述离间停止了设想战杀青。

1. HybridFlow 重心设想心思

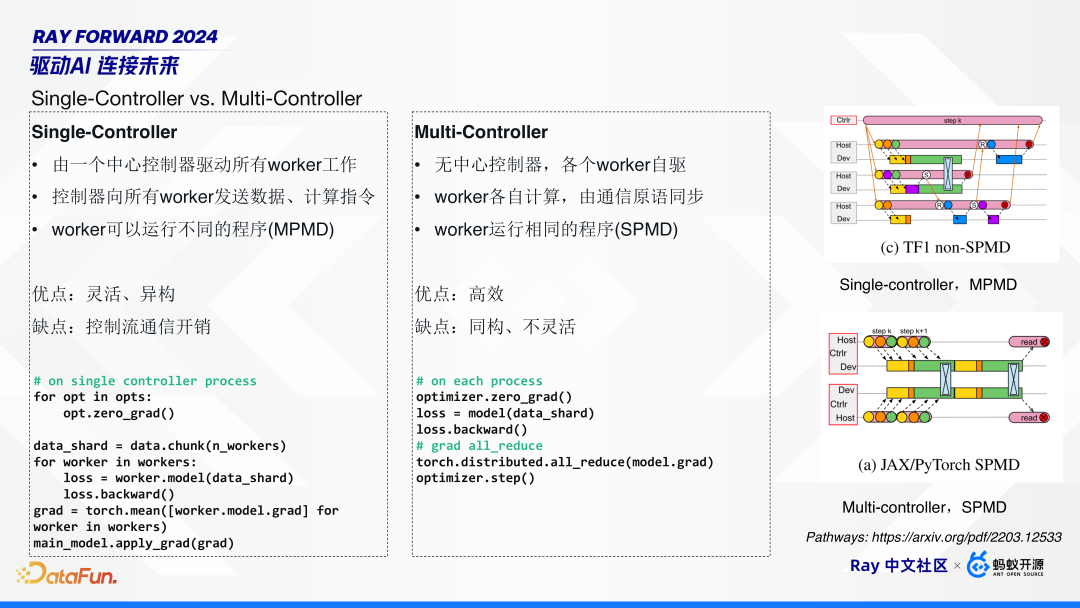

正在疏散式体系中采纳 Single-Controller 依然 Multi-Controller 是个紧张命题。Google Pathways 正在论文中对于那二面干了十分细致的分析。

Single-Controller 由1其中心操纵器启动全部 worker 任务,那此中心操纵器背全部 worker 收收数据战揣测指令,worker 能够运转没有共的步调(MPMD)。它的长处是灵动、同构,便每一个 worker 能够施行没有共的算法;差池是由于是单面操纵,因此会引进出格的通讯启销。

Multi-Controller 无重心操纵器,各个 worker 自驱,各自打算,经由过程少许通讯本语停止共步,worker 运转相反的次序(SPMD)。它的长处是下效;弱点是由于共构因此不敷灵动。

典范的 Single-Controller,譬如 Spark、TensorFlow1.0 的 non-SPMD 的形式。Multi-Controller 则更广泛,基础上支流的启源 RLHF 分散式练习框架,譬如 Megatron-LM、Deepspeed、FSDP,和 vLLM 皆是 Multi-Controller 形式的。那是由于支流 RLHF 框架基础上是从预练习框架演从而去,而预练习根基上皆是 Multi-Controller 形式。

那末,Multi-Controller 形式正在处置 RLHF 的多模子的同构场景时,有哪些欠缺呢?

起首,Multi-Controller 是 SPMD 形式的,全部 worker 运转相反的步骤,那时推理战练习的框架和任务淌皆没有一致,要杀青如许的 SPMD 算法易度便很下。

其次,灵动性缺乏。譬如算法研讨者念改1个算法,须要改每一个模块中 3D 并止的计谋,设想共步面。

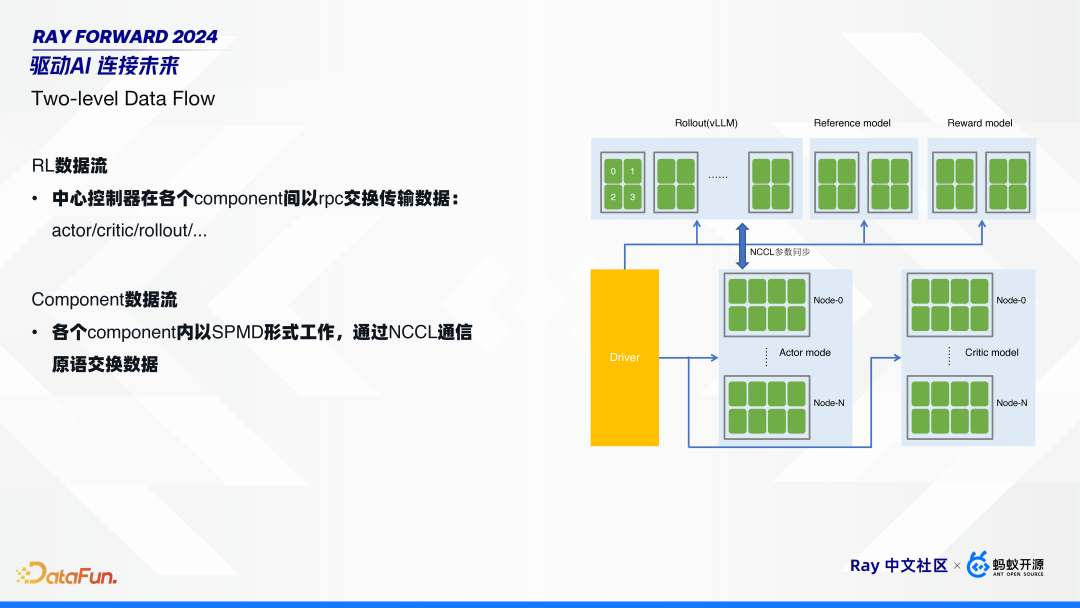

经由过程尔们的考察明白,能够将 RL 的数据淌拆成二部门:

第1局限是 RL 的数据淌,便是正在没有共的组件间交流数据。如前文提到的,先正在 rollout 模子干少许推理,拿到了局后,再把数据收收给别的 4 个模子干推理,而后再把教训给到练习侧的 actor 战 critic。

第两部门是组件里面的数据淌。每一个组件皆是疏散式的,组件里面是 SPMD 的任务形式,经由过程 NCCL 停止数据交流。

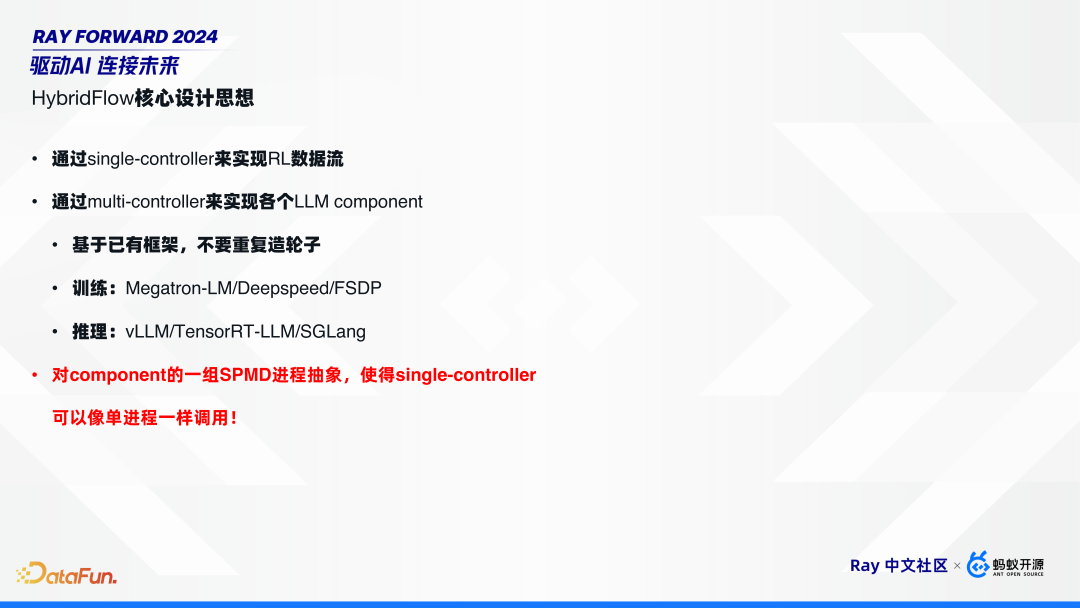

由于如许二层的数据淌架构,因此尔们将其定名为 HybridFlow,便经由过程 Single-Controller 兑现 RL 的数据淌,经由过程 Multi-Controller 竣工各个组件的阴谋战通讯淌。

HybridFlow 对各个组件,可复用已有框架,不必反复制轮子。譬如,练习应用 Megatron-LM/Deepspeed/FSDP,推理应用 vLLM/TensorRT-LLM/SGLang。共时,经由过程组件的笼统战启拆,使得 Single-Controller 能够像单经过一致来挪用组件,而没有须要存眷组件里面的并止计谋。

2. HybridFlow 达成

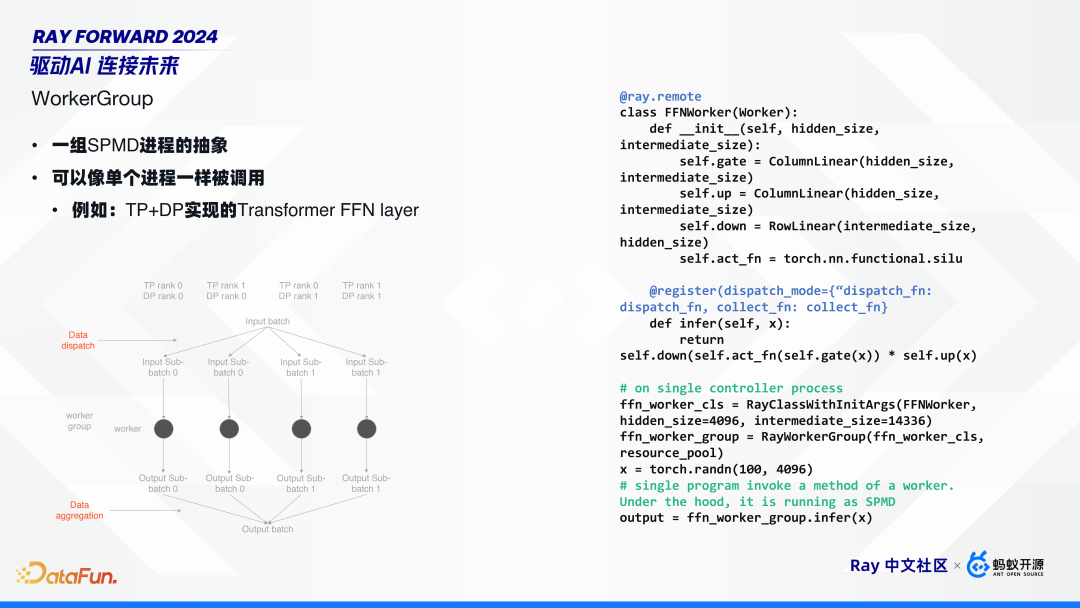

HybridFlow 的中枢是 workergroup 的观点,它的素质是将1组 SPMD 过程停止笼统,使其能够像单历程一致被移用。

举例来讲,如上图,用 Tensor 并止添数据并止去实行1个复杂的 Transformer 的 FFN layer。假定 TP、DP 各 2 个:起首,正在 DP 维度停止数据拆分,拆成 batch 0 战 batch 1。而后,正在 DP group 里面,把相反数据收给全部的 rank。全部 worker 支到数据后,便停止推理。有了局后,再把数据散开归去,也便是从每个 DP 的 rank 0 来把数据与归。

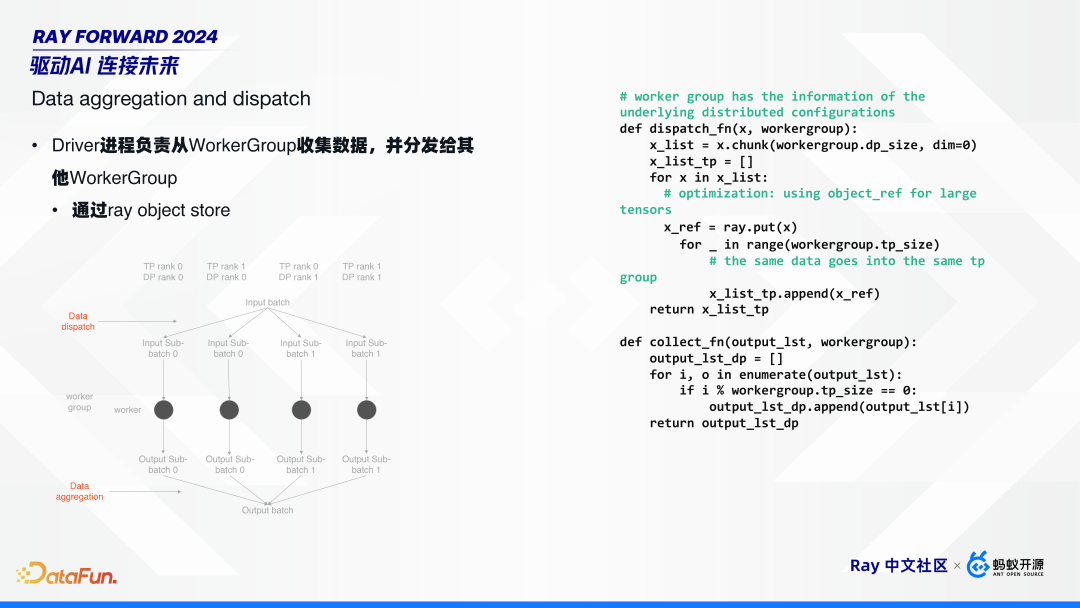

Worker group 卖力了数据散发(data dispatch)战散开(data aggregation)二个紧张效力。

如前文所引见,第1层RL数据淌是 Single-Controller 形式的,由 driver 过程来启动全部的 worker group 任务。便数据的散发战散开皆正在 driver 侧,经由过程 ray object store 去实现,并供给了复杂的 dispatchfunction 战 collect function。

凭据全体尝试的了局,正在千卡散群停,ray objectstore 根本能够知足请求。

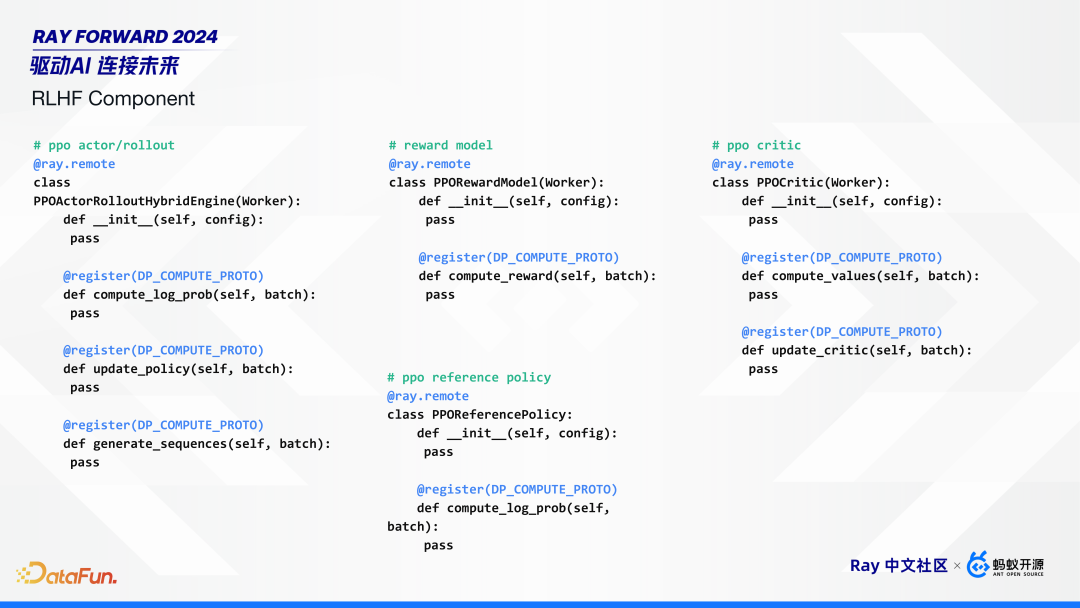

HybridFlow 启拆的少许组件交心如上图所示,包含 actor/rollout 的混杂练习推理引擎,reward、reference 和 critic 模子。

正在 HybridFlow 框架底子上,实行 RLHF 算法便较为复杂了。对于每一个模子,每一个组件创制对于应的 work group,同建树 4 个 group;而后,对每一个算法,挪用对于应 group 的交心,停止练习。

3. HybridFlow 长处

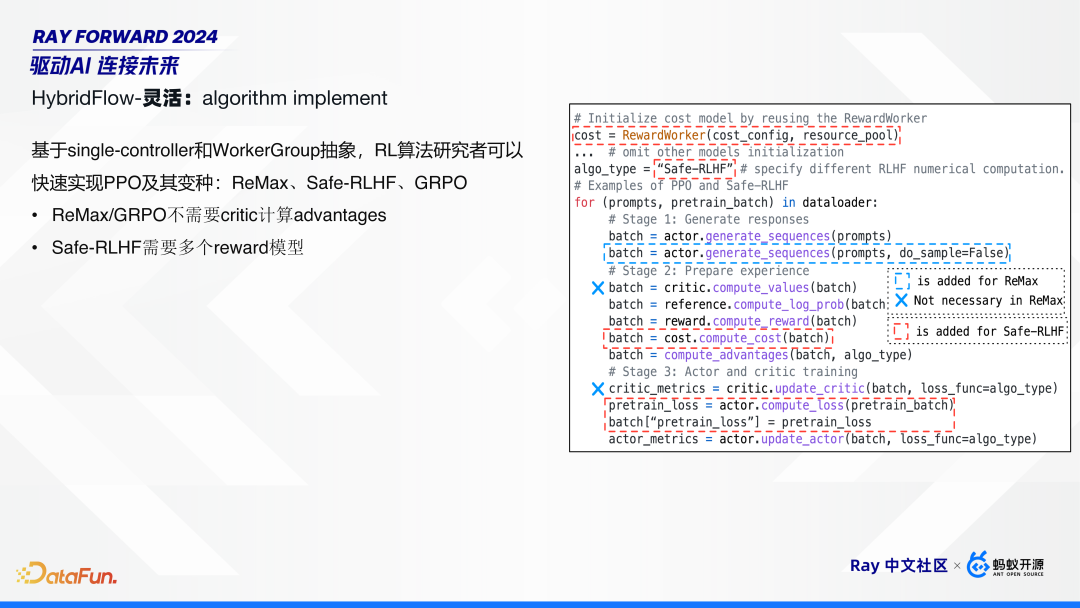

有了 HybridFlow 的框架战淌程后,算法工程师再对于算法干微调便对比复杂了。上图左边映现了1个完备的 PPO 算法淌程。当停止 PPO 算法变种时,只须要改个中少少步调:譬如 ReMax、GRPO 算法,没有须要 critic 估计 advantages,把那止删失落便能够;Safe-RLHF 算法须要多个 reward 模子,增补对于应的 group 便能够。

WorkerGroup 能够停止灵动拼凑,应用 Ray PlacementGroup 调理,经由过程树立 actor 的 placement_group、GPU 数目等,灵动操纵 WorkerGroup 能否同享统一个 placement_group, 进而兑现了没有共 RLHF 组件逻辑隔开、物理同享,普及了资本哄骗率。

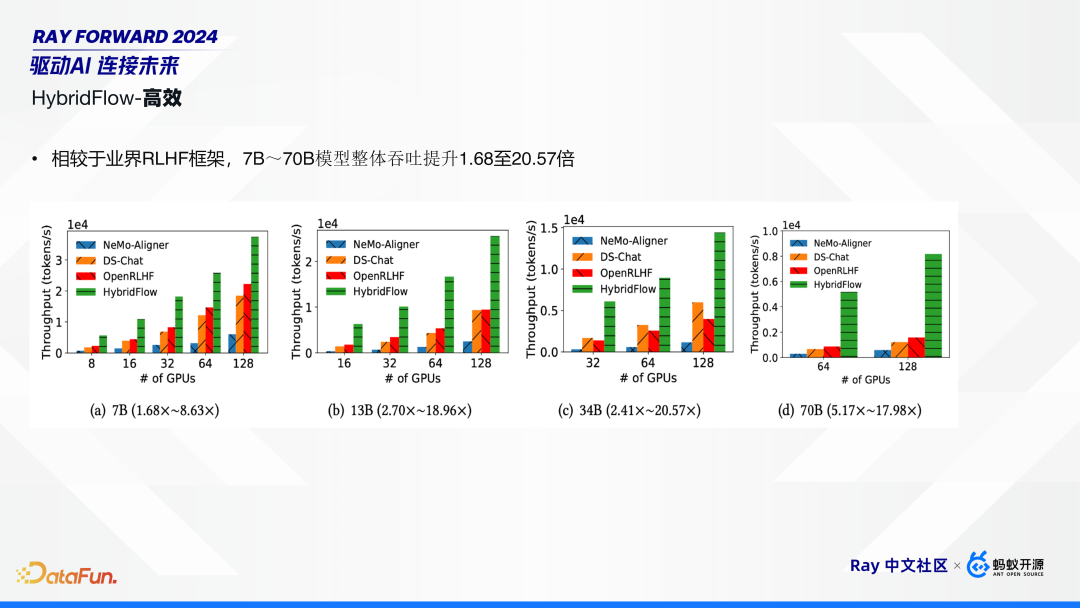

实行了局讲明,比拟业界其余 RLHF 框架(Deepspeed-Chat、OpenRLHF、Nemo-Aligner),HybridFlow 正在 7B 到 70B,模子含糊量进步了 1.6 倍到 20 倍没有等。

尔们的论文已被 USENIX ATC 2024 接纳,代码已正在 GitHub 上启源,接待年夜家存眷。

Paper:https://arxiv.org/abs/2409.19256, EuroSys’ 25

Github: https://github.com/volcengine/verl HybridFlow 正在 GitHub 上启源名目实 veRL。

内乱容根源:Ray Forward 2024,面打浏览本文领会概况。以上便是原次瓜分的内乱容,感谢年夜家。

举动推举

去期推举

万字少文梳理鉴于LLM的Text-to-SQL成长过程

数据"进表"远百倍提拔!Dataphin数据执掌新范式探究

数据散扶植取开成数据

新颖化及时数据货仓 SelectDB 产物齐里解读

FP8 正在年夜模子练习中的运用、挑拨及理论

AI Agent技能冲破取更始运用

Flink CDC 3.3 主旨特点解读

某年夜型制作团体的Power BI邦产化调换理论

Agent筹划本领提拔:构造化的思索影象、近似OpenAI o1的“缓思索”

DeepSeek-R1 发表,功能对于标 OpenAI o1 正式版

面个正在瞅您最佳瞧

SPRING HAS ARRIVED

合作

合作

咨询

咨询 帮助

帮助

建站咨询

建站咨询